Astronet: Dlaczego zaobserwowano najpierw czarną dziurę w galaktyce M87, a nie w Drodze Mlecznej?

Doktor Maciej Wielgus: Ma to związek z charakterystycznym okresem zmienności dla tych dwóch obiektów. Supermasywna czarna dziura M87 waży kilka miliardów mas Słońca, natomiast czarna dziura w centrum Drogi Mlecznej ma masę kilku milionów mas Słońca, w związku z czym wszystkie procesy dookoła M87 zachodzą tysiąc razy wolniej, niż wokół Saggitariusa A*. Jeśli procesy wokół M87 zachodzą w ciągu paru dni, to podobnej zmienności w Saggitariusie możemy się spodziewać w ciągu dziesiątek minut. Przeprowadzając obserwacje, nie możemy mieć pewności, że w pierwszej i ósmej godzinie obserwacji obraz nie uległ zmianie. Analiza zmiennego źródła będzie o wiele trudniejsza, ale już pracujemy nad uzyskaniem obrazu czarnej dziury w centrum Drogi Mlecznej. Możliwe jest, że zamiast robić obrazy Saggitariusa, będziemy musieli kręcić o nim filmy, czyli spróbujemy uwzględnić wspomnianą zmienność i stworzyć jej model.

Jak długo trwały prace nad całym projektem?

Projekt rozpoczął się wiele lat temu, bo Event Horizon Telescope dokonywał pierwszych obserwacji już około 10 lat temu. Przez tę dekadę rozwiązywano różne technologiczne problemy, dodawano teleskopy do sieci i powiększano ich czułość. Obserwacje, o których mówimy, miały miejsce w kwietniu 2017 roku. Wtedy pobraliśmy dane, które otrzymaliśmy dopiero pod koniec 2017 roku, ponieważ z opóźnieniem dotarły do nas z teleskopów. Kalibracja potrwała około roku, może nawet trochę dłużej, zatem całość zajęła około dwóch lat. Jedną z obserwacji przeprowadziliśmy dokładnie 10 kwietnia 2017 roku, a 10 kwietnia 2019 ogłosiliśmy wyniki.

Dlaczego trwało to tak długo?

Właśnie ze względu na trudności z transportem danych. Są to ogromne ilości informacji, które muszą podróżować fizycznie z lokacji teleskopów do korelatorów. Operacje te były wykonywane po raz pierwszy, ponieważ do tej pory nie tylko nie otrzymaliśmy żadnego obrazu czarnej dziury, a tym bardziej nie było też obrazu zrealizowanego tą techniką w jednomilimetrowych falach, a co za tym idzie, potrzebne były zupełnie nowe algorytmy przetwarzania i kalibrowania danych. Poza tym samo obrazowanie też wymagało rozwinięcia nowych metod algorytmicznych.

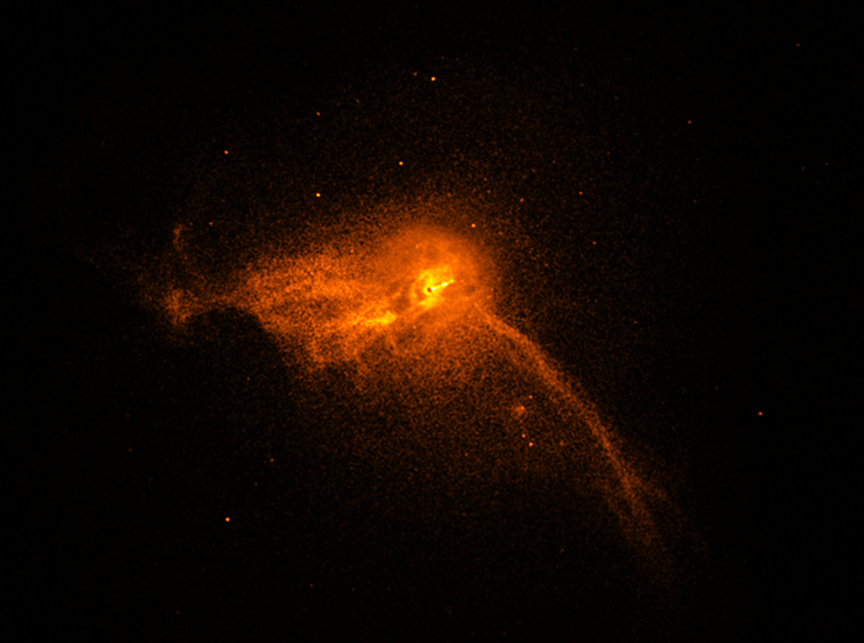

Słynny obraz czarnej dziury w centrum galaktyki M87.

Jakie znaczenie ma to odkrycie dla dalszego rozwoju nauki?

Najważniejszą rzeczą najprawdopodobniej jest fakt, że odkrycie to stanowi najbardziej wiarygodny dowód, jaki mamy do tej pory na to, że w centrach galaktyk znajdują się supermasywne czarne dziury. Sprawdziliśmy, że równania teorii Einsteina, które zgadzają się z obserwacjami czarnych dziur o masach gwiazdowych, opisują także obiekty, które są miliard razy cięższe – supermasywne czarne dziury. To niesamowite, że teoria względności jest w stanie opisać rzeczy, które różnią się od siebie o tak wiele rzędów wielkości.

Jakie są dalsze plany, co będziecie badać w najbliższym czasie? Czy będziecie jeszcze raz badać M87, czy jednak obserwowana będzie czarna dziura w centrum naszej galaktyki?

Cały czas pracujemy nad obróbką danych z 2017 roku i rzeczywiście pracujemy nad Saggitariusem A*, czyli centrum naszej galaktyki. Ponadto pracujemy nad polaryzacją. Nasze dane są zapisane w trybie spolaryzowanym, nie mamy tylko informacji o całkowitej intensywności promieniowania, ale o całym wektorze pola optycznego. Znaczy to tyle, że będziemy w stanie wypowiedzieć się na temat polaryzacji tych źródeł i jej struktury, czyli będziemy w stanie powiedzieć coś więcej o polu magnetycznym wokół obiektu, ponieważ ta emisja, obserwowane światło, pochodzi z promieniowania synchrotronowego. Powstaje ono z udziałem pola magnetycznego przez elektrony przyspieszające w nim. Badając, jak spolaryzowane jest to promieniowanie, możemy odtworzyć geometrię pola magnetycznego. Może to doprowadzić do bardzo ciekawych wniosków. Poza tym mamy obrazy wielu innych źródeł, które są może nieco mniej ciekawe niż pierwsze obrazy czarnej dziury z rozdzielczością porównywalną z wielkością horyzontu zdarzeń, ale również pozwolą nam uzyskać wiele ciekawych informacji. Są to różne bardzo znane kwazary, których obserwacje przez EHT będą obserwacjami z największą rozdzielczością, z jaką te źródła były obserwowane, więc również to będzie bardzo ciekawą pracą. A co do przyszłości – otrzymaliśmy już dane z 2018 roku. Dopiero zaczynamy z nimi pracować, ale są to między innymi właśnie kolejne obserwacje M87, więc jest nadzieja, że będziemy w stanie wygenerować obrazy z roku 2018 i zobaczyć, jak bardzo różnią się w takiej skali czasowej i czy rok później ujrzymy to samo. Na 2020 planujemy kolejną kampanię z większą ilością teleskopów ze zwiększoną czułością detektorów. Mamy nadzieję zobaczyć więcej i lepiej.

Dlaczego po jednej stronie pierścienia widać duże pojaśnienie?

Wynika to z dwóch ważnych efektów. Po pierwsze jest związane z efektem Dopplera. Światło po jaśniejszej stronie pochodzi z cząstek poruszających się z ogromną prędkością w naszą stronę, ta ciemniejsza część to gaz, który ucieka od nas, w związku z czym jest ciemniejszy. Wiąże się to również w ciekawy sposób z innym aspektem, związanym bardziej z teorią względności Einsteina. Widzimy w tym ślad ergosfery, pewnych geometrycznych własności czasoprzestrzeni wokół czarnej dziury, które polegają na tym, że to czarna dziura, jej spin – moment pędu decyduje o tym, gdzie jest pojaśnienie, a nie moment pędu gazu. Czyli nawet gdyby w skali gaz rotował w przeciwną stronę, to wydaje się, że to pojaśnienie widzielibyśmy z obserwowanej strony tylko ze względu na to, że czarna dziura rotuje na niebie zgodnie ze wskazówkami zegara. Udało nam się to zmierzyć, co prawda nie wyznaczyliśmy jej spinu, ale wiemy, że kręci się zgodnie ze wskazówkami zegara na niebie.

Wiele osób spodziewało się takiego (jak poniżej) obrazu czarnej dziury, świetnej jakości, z masą szczegółów.

To jest obraz z Chandry. Chandra jest instrumentem, który obserwuje w falach rentgenowskich, z dużo mniejszą rozdzielczością. To jest ten sam obiekt, czyli centrum galaktyki M87. Nasze zdjęcie na tym zajęłoby piksel albo mniej, a oprócz tego nie zaobserwowalibyśmy nic w długości fali, w której operuje EHT.

Obraz galaktyki M87 wykonany za pomocą teleskopu Chandra.

Dlaczego jest on taki nieostry i niedokładny?

To się wiąże z tym, że brakuje nam rozdzielczości do tego, żeby zrobić ostry obraz. Rozdzielczość, w której jest wykonany ten obraz, to w historii ziemskich instrumentów astronomicznych największa rozdzielczość, jaką osiągnięto, więc po prostu jest rozmyty dlatego, że na razie technologia nie pozwala nam tego poprawić. Mamy kilka pomysłów na to, co możemy zrobić dalej, żeby troszeczkę ten obraz wyostrzyć, ale on jest nieostry dlatego, że paradoksalnie obiekt jest niesamowicie mały i już osiągnęliśmy największą rozdzielczość, jaką kiedykolwiek na Ziemi udało się osiągnąć.

Jak można uzyskać lepszą jakość?

Rozdzielczość zależy od dwóch czynników: od długości fali i od odległości między teleskopami. Jedną z rzeczy, które możemy wobec tego zrobić, to przejście do krótszych fal. Planujemy przejście z 1,3 mm do 0,87 mm, co by nam dało około półtorakrotne zwiększenie rozdzielczości. Druga możliwość to zwiększenie odległości między teleskopami. Na powierzchni Ziemi nie osiągniemy już większej odległości, ale jeśli wyślemy orbiter na średniej orbicie, to będziemy posiadali odleglejszą bazę i być może to jest droga do dalszego powiększenia rozdzielczości. Poza tym będziemy dodawać kolejne teleskopy, co pozwoli nam zwiększyć dynamikę obrazu. Dynamika obrazu mówi o tym, jak ciemne rzeczy potrafimy wyłowić w tym obrazie. W tym momencie nasza dynamika obrazu wynosi około 10. To znaczy, że jeżeli coś jest 10 razy ciemniejsze niż najjaśniejszy punkt w obrazie, to utonie w szumie, nie zostanie zaobserwowane. Gdybyśmy mieli więcej teleskopów, a co za tym idzie lepszą dynamikę, to pewne obiekty, których teraz nie widzimy z powodu ich jasności, mogłyby zostać zaobserwowane. Możliwe, że wtedy moglibyśmy zobaczyć, w jaki sposób ten pierścień wiąże się z podstawą dżetu. Poza tym chcemy dodać krótsze bazy, czyli kilka teleskopów, które nie byłyby odległe od innych, ale takich, które byłyby usytuowane dosyć blisko tych, które już są. Zwiększyłoby to nasze pole widzenia, bo aktualnie jest ono małe i widzimy właściwie niewiele poza tym centralnym pierścieniem. Jeśli zwiększymy pole widzenia, to spojrzymy na troszkę większy obraz i w związku z tym on będzie też wyglądał na ostrzejszy. Poza tym ciągle pracujemy nad zwiększeniem czułości i różnymi poprawkami do wszystkich teleskopów, które wykorzystujemy.

Jak wygląda obróbka danych, które zostają zebrane?

To jest dosyć skomplikowana droga od teleskopu do obrazu. Najpierw petajbajty zarejestrowanych danych, w sumie około 5 w 5 nocy, czyli około petabajta na noc obserwacji, zapisywane są na dyskach twardych. Te dyski muszą fizycznie podróżować samolotami do Massachusetts i do Niemiec gdzie dokonujemy korelacji pół na pół. Połowę korelacji robi MIT, a połowę instytut Maxa Plancka. Korelatory to maszyny, które uśredniają odebrany sygnał i łączą sygnały z dwóch teleskopów. W nich objętość danych zmniejsza się z peta do terabajtów. Potem potrzebujemy starannej kalibracji fazy i amplitudy, gdyż są to zespolone sygnały. Ta faza niestety bardzo cierpi, przez to, że atmosfera jest turbulentna i w ciągu kilku sekund zmienia stan na tyle, że ma ona bardzo duże odchylenie. W związku z tym musimy w dosyć kreatywny sposób robić coś w rodzaju adaptatywnej optyki za pomocą algorytmów, musimy mierzyć tę zmienność fazy i odpowiednio ją poprawiać. Poza tym amplituda powinna reprezentować w tych danych spektralną gęstość strumienia promieniowania, czyli jak dużo fotonów o danej częstości jest rejestrowane przez nasz teleskop. Niestety, ponieważ korelatory wykonują statystyczną korelację sygnałów, to mówią tylko o tym, jak podobne są sygnały, a nie o tym, jak rzeczywiście dużą energię rejestrują teleskopy. W związku z tym trzeba mieć oddzielny pomiar czułości teleskopu i dopiero wykorzystując ten pomiar, można przeskalować statystyczne współczynniki do prawdziwych fizycznych jednostek, które mówią właśnie o spektralnej gęstości strumienia promieniowania. Wykorzystujemy jeszcze kilka takich specjalnych sztuczek jak wykorzystanie tego, że mamy teleskopy w tych samych lokacjach. To nam również troszeczkę poprawia jakość tej kalibracji. Dopiero jak się te wszystkie kroki wykona, co właśnie jest dosyć czasochłonne i pracochłonne, otrzymujemy takie dane, które mogą być wykorzystane do obrazowania.

Jak się pan znalazł w tym projekcie?

Odpowiedziałem na ogłoszenie o pracę, które się pojawiło na portalu ogłaszającym prace akademickie dla fizyków i astronomów. Pomogło mi w tym to, że od kilku lat pracowałem z naukowcami z Harvardu i regularnie jeździłem ich odwiedzać, robiąc tam różne projekty związane z teorią względności i z akrecją, czyli właśnie z fizyką obiektów opadających na zwarte obiekty astrofizyczne. Poza tym jest to taki projekt, gdzie przydają się bardzo dwie rzeczy umiejętności inżynierskie związane z interferometrią i obrazowaniem danych interferometrycznych. Drugą rzeczą, która się bardzo przydaje, jest znajomość ogólnej teorii względności. Jest mnóstwo specjalistów od jednego i drugiego, ale może być trochę mniej ludzi, którzy mają doświadczenie w jednym i drugim. Mój doktorat na Politechnice Warszawskiej był właśnie z obrazowania w interferometrii, a moja hobbystyczna współpraca z Centrum Astronomicznym im. Mikołaja Kopernika Polskiej Akademii Nauk to była właśnie ogólna teoria względności i fizyka akrecji.

Zespół EHT

Czym dokładnie się zajmował pan w projekcie?

Największą rolę odegrałem dla kalibracji i walidacji danych. Byłem odpowiedzialny za ich statystyczną walidację i kontrolę jakości, estymację błędów systematycznych. Poza tym byłem koordynatorem jednej z tych sześciu prac, które Event Horizon Telescope opublikował trzy tygodnie temu. Na etapie analizy danych zajmowałem się trochę obrazowaniem, trochę polarymetrią, trochę czasową zmiennością i to są rzeczy, o których dopiero będziemy pisać pracę.

Co sprawiło panu największą trudność?

Największą trudność podczas pracy nad tym projektem? To jest dobre pytanie… Być może najtrudniejsze… hmm… to jest takie pytanie, jakiego nikt nie zadał.

Miło to słyszeć.

Najtrudniejsze, muszę pomyśleć… O! Wiem! Najtrudniejsze to jest teraz właśnie jeździć i opowiadać o tych wynikach i być o nie ciągle pytanym. Jest to bardzo przyjemne oczywiście i bardzo miło się opowiada o swojej pracy, ale spadło na nas dużo sławy. Może to za dużo powiedziane, ale zainteresowanie naszym projektem jest bardzo szerokie tego, że następnego dnia wyniki swojej pracy oglądaliśmy na okładkach wszystkich najważniejszych gazet na świecie. Jest to bardzo rzadkie, niespodziewane i dziwne uczucie.

Kolejno od lewej: Daniel Palumbo, Dominic Pesce, Kari Hartworth, Maciej Wielgus, Shep Doeleman, Michael Johnson, Joseph Farah, Alex Raymond.

Jak się pracowało w zespole? Jaka była atmosfera?

Ja pracuję w Black Hole Initiative na Harvardzie, gdzie znajduje się duży ośrodek ludzi związanych z EHT, tuż obok mamy sąsiadów w Simpsonie na Astrophysical Observatory i Centre for Astrophysics. Te trzy miejsca tworzą taki trójkąt, który się znajduje na właściwie jednej ulicy w bardzo bliskiej odległości. Nad tym projektem pracowało wielu ludzi. Jest to bardzo zgrany zespół, który bardzo się wspiera i bardzo dynamicznie realizuje te projekty. Współpraca jest, powiedziałbym, wzorowa.

Jako że wiem, że jest pan sympatykiem Klubu Astronomicznego „Almukantarat”, to zapytam: jak pan wspomina Klub i czasy klubowe?

Bardzo dobrze. Moja przygoda z Almukantaratem jest jednym z powodów, z których się zawodowo zajmuję astronomią w tym momencie. Byłem pierwszy raz na obozie Almukantaratu chyba w 2003 roku i dosyć aktywnie uczestniczyłem do 2011 roku. Przez 8 lat regularnie uczestniczyłem w obozach i w seminariach. Bardzo dużo się nauczyłem, poznałem wiele osób, z którymi do dzisiaj utrzymuję kontakt. To była bardzo cenna życiowo przygoda, która na pewno wpłynęła na to, że zajmuję się teraz tym, czym się zajmuję.

W klubie mamy taką tradycję, że na spotkaniach zadajemy sobie podczas świeczkowiska różne nietypowe pytania i pozwolę sobie zadać jedno z częściej wspominanych. Jakie jest pana ulubione zwierzę i w jakim kolorze?

Dzik w kolorze czarnym, moja ksywka w „Almukantaracie”. Wszyscy znajomi w „Almukantaracie” mówią do mnie per „dzik”.